Utiliser une IA est devenu aujourd’hui aussi simple qu’utiliser un moteur de recherche. Mais cette facilité cache une réalité énergétique bien plus complexe. Car les modèles qui tournent derrière chaque requête sont particulièrement énergivores. Devant la croissance colossale de ses besoins, Microsoft envisage un projet tout aussi colossal.

L’IA s’introduit peu à peu dans nos vies, aussi bien pour réaliser des recherches générales, que pour automatiser des tâches répétitives, que ce soit du texte ou du développement informatique, ou pour générer des images, voire des films ou encore de la musique.

Dans ce contexte, Microsoft ne pouvait rater ce virage technologique. Le géant américain a en effet misé gros sur l’IA. La société s’appuie notamment sur la société OpenAI et son modèle phare : le générateur de texte ChatGPT, et le générateur d’image DALL-E. Et les montants sont colossaux : en 2019, Microsoft investit 1 milliards de dollars dans OpenAI, suivis en février 2023 par un investissement supplémentaire de 10 milliards de dollars. Un investissement vraisemblablement rentable, puisque la société est aujourd’hui valorisée à hauteur de 80 milliards de dollars.

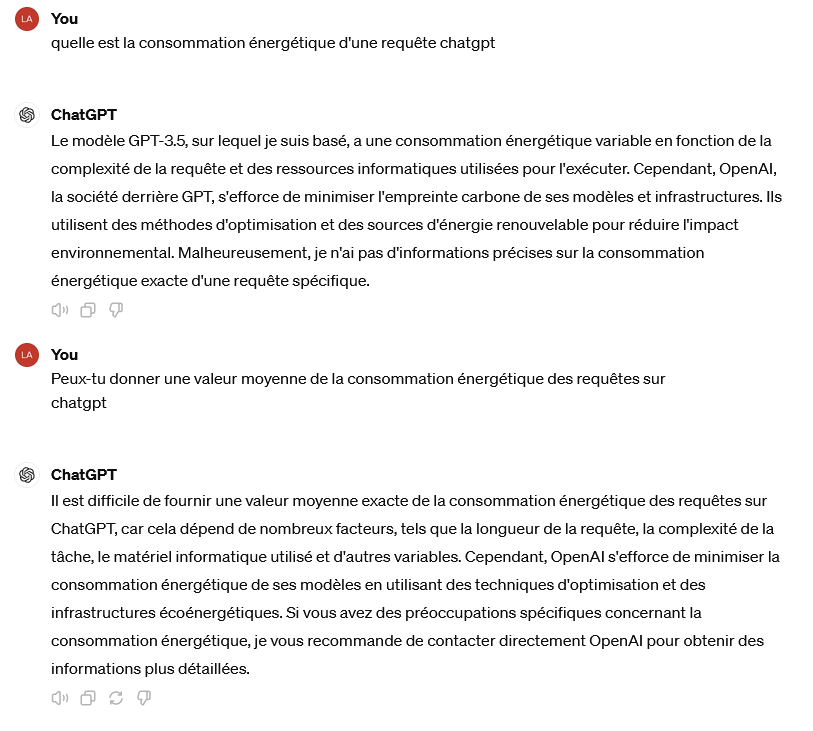

À lire aussiComment l’IA pourrait révolutionner la production de méthanol à partir du CO2Face à ces milliards de dollars, revenons à nos sujets de prédilection et posons la question en ces termes : combien de milliards de watts-heures consomme l’IA ? Posons la question directement à ChatGPT :

L’IA ne nous aura donc pas été d’une grande aide en l’occurrence. Mais creusons. D’après un article de Luccioni et collègues, publié en 2022 sur la plateforme Arxiv, l’entraînement de BLOOM, un modèle contenant 176 milliards de paramètres, représente plus d’un million d’heures de calcul, une dépense énergétique de l’ordre de 500 MWh et des émissions de CO2 de l’ordre de 50 tonnes. Le modèle GTP-3 de ChatGPT comprend 175 milliards de paramètres, et l’on peut supposer que son entraînement a conduit à consommer une quantité similaire d’énergie. L’entraînement d’un modèle de ce type, appelé LLM pour Large language model (en français : Grand modèle de language), consomme donc l’équivalent de ce que consomment chaque année environ 100 foyers en France.

Qu’en est-il de l’utilisation du modèle, une fois ce dernier entraîné ? L’Agence internationale de l’énergie (IEA) fournit pour sa part quelques estimations dans son analyse 2024 du secteur électrique. Elle indique notamment (p 34) : « En comparant la demande moyenne d’électricité d’une recherche Google (0,3 Wh d’électricité) au ChatGPT d’OpenAI (2,9 Wh par requête), et en considérant 9 milliards de recherches quotidiennes, cela nécessiterait près de 10 TWh d’électricité supplémentaire en un an. ».

D’après l’IEA, donc, une requête utilisant l’IA consomme dix fois plus d’énergie qu’une requête de moteur de recherche classique. En faisant l’hypothèse d’une requête par personne et par jour, l’agence estime donc les besoins à 10 TWh/an. C’est un peu moins que ce que peut produire un réacteur nucléaire de type EPR, à savoir environ 12 TWh/an. Pour fixer les ordres de grandeur, la production d’électricité en France en 2020 est de l’ordre de 500 TWh. La consommation de l’IA est donc significative, et il est possible que le besoin s’avère à l’avenir nettement plus grand que celui estimé par l’IEA.

À lire aussiCe gigantesque datacenter d’Amazon sera directement alimenté par une centrale nucléaireMicrosoft s’est engagé à ce que ses besoins énergétiques soient assurés à 100% par des moyens renouvelables d’ici 2030. La prise en compte de la consommation d’énergie de l’IA, et de l’explosion potentielle de son marché et de son utilisation conduit donc à prévoir des moyens de production d’énergie à la hauteur.

Par le biais d’un projet signé avec Brookfield Asset Management, Microsoft prévoit ainsi de développer au moins 10,5 GW de capacité renouvelable, pour ses besoins propres. Ces capacités seront réparties sur la plupart des continents : États-Unis, Europe, Amérique latine, Asie et Pacifique. L’investissement serait compris entre 11,5 et 17 milliards de dollars sur la durée du programme. Nous pouvons souhaiter qu’au-delà de la taille des moyens de production, une optimisation des outils conduise par ailleurs à une réduction de leur consommation d’énergie. Vers « l’IA sobre », en quelque sorte.

La suite de votre contenu après cette annonce

Notre Newsletter

Ne ratez plus les dernières actualités énergetiques

S'inscrire gratuitement